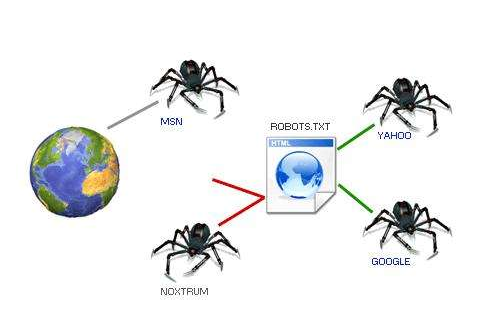

很多剛接觸SEO的朋友還不怎么了解robots是什么,其實robots是一個跟目錄文件,雖然操作和用處極為簡單,但是它在SEO優化推廣中的有著至關重要的意義。

它的用處就是指定哪些搜索引擎蜘蛛可以抓取內容,以及禁止搜索引擎蜘蛛抓取網站的部分或全部內容。看到這里想必已經明白了吧,就是說不小心禁止某個搜索引擎抓取(比如百度),那么在這搜索引擎上就不會有收錄更別說排名了,也就搜索不到網站里面的任何內容。

那么怎么使用呢?

Robots.txt 文件放在網站根目錄下,并且該文件是可以通過互聯網進行訪問的。 例如:如果您的網站地址是 http://live2last.com/那么,該文件必須能夠通過 http://live2last.com/robots.txt 打開并看到里面的內容。

如果要調整改動就需要通過FTP鏈接服務器進行改動了,云主機可以通過遠程桌面直接修改,有些主機供應商的管理后臺有支持文件控制的也可以直接操作修改。

里面涉及到的幾個點分別是【User-agent】【Disallow】【Allow】【Sitemap】

User-agent:用于描述搜索引擎robot的名字,在"robots.txt"文件中,如果有多條User-agent記錄說明有多個robot會受到該協議的限制,對該文件來說,至少要有一條User-agent記錄。如果該項的值設為*,則該協議對任何機器人均有效,在"robots.txt"文件中,"User-agent:*"這樣的記錄只能有一條。

Disallow:用于描述不希望被訪問到的一個URL,這個URL可以是一條完整的路徑,也可以是部分的,任何以Disallow開頭的URL均不會被robot訪問到。

Allow:用于描述希望被訪問的一組URL,與Disallow項相似,這個值可以是一條完整的路徑,也可以是路徑的前綴,以Allow項的值開頭的URL是允許robot訪問的。

Sitemap:用于標注網站地圖鏈接sitemap.xml,增加Sitemap谷歌為xml格式,百度為html格式

例如:

User-agent: Baiduspider【允許百度蜘蛛收錄】

Disallow: User-agent: Sosospider【禁止搜搜蜘蛛收錄】

Disallow: /bin/【禁止抓取bin文件里面的內容】

Allow:/product/【允許抓取product欄目類容】

Sitemap: http://live2last.com/sitemap.xml【本站的網站地圖是sitemap.xml】

365*24小時全國統一服務熱線

0769-22039555

服務熱線:13827298991(陳先生)/18825771900(黃小姐)

技術專線:0769-22039111 郵箱:dgce@dgce.com.cn

地址: 南城街道宏一路G1蜂匯1棟寫字樓803、804

華商微信公眾號

今日已有165人獲取方案